A adoção do resfriamento líquido aumentou drasticamente nos últimos anos devido ao rápido aumento do consumo de energia pelas unidades de processamento gráfico e circuitos integrados (GPU/ASIC) específicos de aplicação para as cargas de trabalho de IA e ML. A adoção pelos provedores de serviços de cloud computing (CSPs) e pelas OEMs também aumentou rapidamente uma vez que o consumo de energia da CPU aumentou de estimados 100 W em uma década para mais de 400 W nos últimos cinco anos. O uso de energia pelas GPUs/ASICs aumentou dramaticamente em comparação com as CPUs, com a potência aumentando em milhares de watts anualmente. Fornecedores de chips, como a NVIDIA, AMD e Intel, registraram potências de GPUs acima de 1 kW. Além disso, CSPs como a Microsoft, a Google, a Amazon e a Meta estão projetando seus chips para cargas de trabalho de IA/ML, com seus futuros chips requerendo resfriamento líquido.

Em colaboração com alguns membros do Open Compute Project (OCP), como AMD, Intel, Meta, NVIDIA, Samsung e Vertiv™, publicamos um white paper chamado "Refrigerante a 30 °C - Um Roadmap Duradouro para o Futuro". O estudo fornece insights de planejamento empresarial e eficiência na manutenção de temperaturas ótimas para a longevidade de equipamentos, estabilidade da cadeia de suprimentos e responsabilidade ambiental.

Arquitetura das GPUs: O empilhamento térmico nos chips modernos

As GPUs modernas passaram por uma mudança drástica na construção de seu pacote de silício, utilizando o empilhamento em 2,5 dimensões (2.5D) de múltiplos chiplets (Chip-on-Wafer-on-Substrate, ou CoWoS) para aprimorar a performance da computação. Isso abrange combinar sistema em um chip (SOC) com memória de alta largura de banda (HBM), permitindo que um tipo diferente e uma quantidade diferente de chiplets sejam combinados para pacotes de GPUs com maior performance. As melhorias na tecnologia de processamento, nas técnicas de montagem dos pacotes, nos requisitos de performance do processamento e a partilha da memória são as grandes responsáveis pelos grandes aumentos de potência vistos nas GPUs.

Em comparação, a complexidade na construção das GPUs é muito maior do que na construção das CPUs e provoca da mesma forma desafios térmicos únicos no pacote, a saber:

- Os diferentes chiplets ou componentes demandam diferentes temperaturas máximas de junção.

- Os diferentes chiplets têm diferentes alturas de empilhamento.

Por exemplo, o chiplet SOC normalmente opera com uma temperatura de junção máxima de 105 °C, enquanto a HBM requer uma temperatura de junção menor de 85 °C para uma única atualização e 95 °C para uma operação de atualização dupla nas primeiras gerações. As temperaturas para as gerações mais recentes de HBM foram aumentadas para 95 °C e 105 °C respectivamente, para ter uma melhor equiparação com os requisitos para a temperatura de junção. Cada fabricante de HBM está tentando lidar com essa tendência de acordo com a sua expertise.

Durabilidade sob a perspectiva de um fabricante e de um operador

É do melhor interesse dos fabricantes de chips de silício ter um data center duradouro para estabelecer que os requisitos para a temperatura dos chips não mudarão a cada geração. A nova geração de produtos de IA têm designs térmicos que necessitam que as temperaturas do refrigerante sejam significativamente menores do que aquelas que alguns dos projetistas de data centers planejam atualmente. Ao concordar com um refrigerante padrão, os fabricantes de chips podem projetar seus produtos com a certeza de que eles possam ser suficientemente resfriados. Além disso, uma temperatura determinada proporciona uma boa direção de design para os fabricantes de chips.

Enquanto isso, os operadores de data center se beneficiam em alinhar uma temperatura duradoura para o refrigerante por várias razões. Embora leve diversos anos para planejar, projetar, construir e comissionar um data center, os chips de silício estão evoluindo rapidamente. A indústria se beneficia das rápidas interações com os chips. Mas se o limite inferior do refrigerante necessário para implementar chips de IA mudar rapidamente, os novos data centers podem se tornar obsoletos antes mesmo de serem construídos. É também relativamente fácil e eficiente operar um circuito do sistema de resfriamento de tecnologia (TCS) na base de sua faixa mais alta de temperatura. Entretanto, uma vez que o circuito de TCS está feito, é muito caro e demorado modificá-lo para operar abaixo da sua faixa de temperatura de design. Portanto, definir o limite inferior da temperatura do um circuito de TCS de um data center é muito importante para o investimento e a viabilidade da infraestrutura do data center no longo prazo.

Determinando a temperatura certa para o data center moderno

Data centers devem ser projetados para temperatura e taxa de vazão específicas de operação do refrigerante. Se o requisito de temperatura para uma geração específica de hardware de TI for mais alto, os setpoints operacionais do data center podem ser ajustados para aumentar a temperatura do refrigerante. Isso oferece a oportunidade para maior eficiência. Se o requisito de temperatura for menor do que a temperatura de design do data center, serão necessárias modificações caras e demoradas no design físico. Por exemplo, temperaturas mais baixas podem requerer capacidade adicional do chiller ou um novo tipo de chiller. Dadas as consequências de tal mudança, é importante determinar o requisito de temperatura do refrigerante de forma que ele não mude durante diversas gerações de hardware de TI.

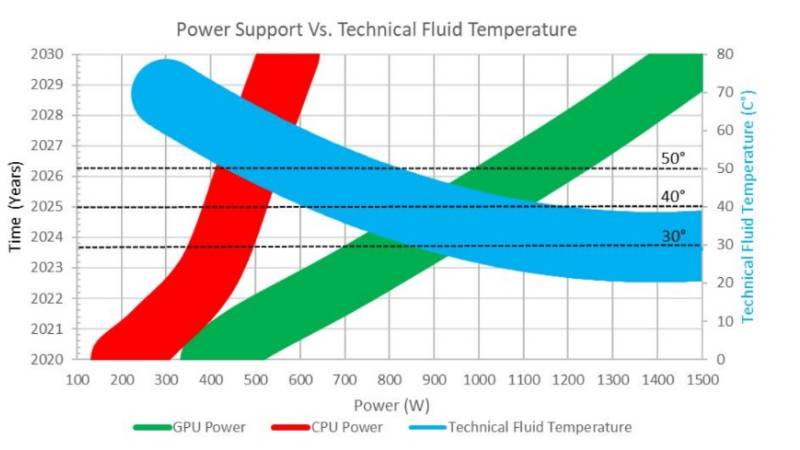

Isso é um grande desafio para o hardware de IA, dadas as rápidas mudanças nos requisitos térmicos e de potência dos chips. A Figura 2 ilustra as tendências das potências das GPUs e CPUs e os requisitos de temperatura técnica dos fluidos associados (Figura 6 no white paper). O hardware de IA está impulsionando a necessidade por resfriamento líquido. A potência das GPUs está aumentando muito mais rapidamente do que a potência das CPUs. O gráfico mostra os requisitos de temperatura dos fluidos associados das GPUs ao longo do tempo: o requisito da temperatura assintótica é de 30 °C.

Figura 2. Tendência nas potências das GPUs e CPUs e os requisitos de temperatura técnica do fluido associado a 1,5 gpm por 1 kW. Fonte: Open Compute Project®, apresentação “Coolant Temperatures for Next Generation IT and Durable Data Center Designs, Summit Regional da OCP, abril de 2023.

Concordamos com 30 °C como sendo a temperatura mínima do fluído para o design de hardware e de data centers. A espessura da linha representa incerteza na previsão. São necessários investimentos em empacotamento avançado de chips e no desempenho do resfriamento líquido para manter 30 °C como uma especificação para interfaces no longo prazo. A escolha por 30 °C se equipara a uma especificação comum para a temperatura mínima do ar em designs de data centers de grande porte. Escolher o mesmo valor para hardware resfriado a ar e resfriado a líquido permite que a indústria mantenha as melhorias significativas na PUE (eficácia no uso da energia) alcançadas nos últimos 15 anos. As consequências da redução na temperatura do fluido de 30°C para 20°C, e a redução das horas de free-cooling durante o ano em zonas classificadas como sendo de temperaturas mais quentes, podem ser lidas no white paper.

Embora o resfriamento líquido em sistemas de computação esteja disponível há várias décadas, a demanda pelo resfriamento de cargas de trabalho de maior densidade está levando o resfriamento líquido de um nicho de data centers 'boutique' para os data centers hyperscale. Devido à disparidade no desenvolvimento e na evolução entre os cronogramas de soluções para IA e para construção de data centers, os operadores de data centers e os fornecedores de chips precisam concordar em uma temperatura de refrigerante que permita ao chip ser duradouro.

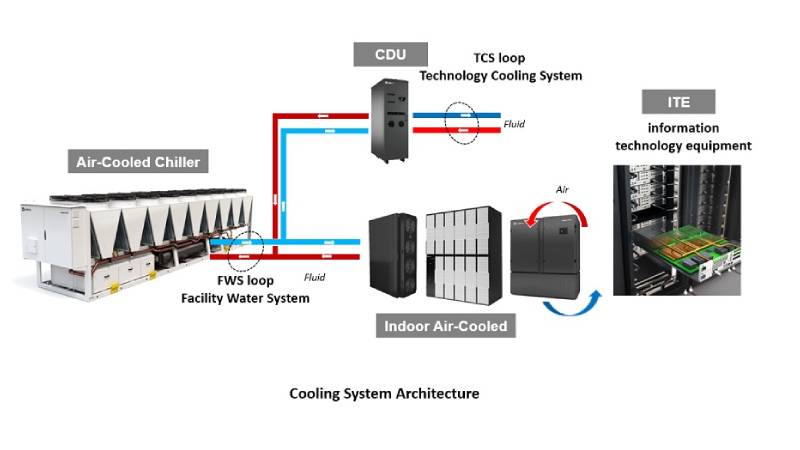

Uma temperatura mínima de 30 °C do refrigerante para o circuito do TCS oferece um setpoint que proporciona um ponto de operação para ambas as partes. Considerando uma visão simplificada da arquitetura de resfriamento de um data center, há pelo menos dois circuitos de resfriamento em um sistema de resfriamento líquido do TCS para o sistema de água da instalação (FWS), conforme mostrado na Figura 3 (Figura 8 no white paper).

Figura 3. Arquitetura e componentes do sistema de resfriamento

Resfriando a IA com confiança

A limite de 30 °C para a temperatura do refrigerante do TCS não pretende desencorajar o desenvolvimento de uma grande variedade de soluções futuras. Embora haja um valor importante no alinhamento da temperatura de um refrigerante em 30 °C ou mais, não há o desejo de limitar os tipos de tecnologia usados para entregar a capacidade de resfriamento ao chip. A liberdade de inovação será necessária para diferentes tecnologias de resfriamento, de forma a proporcionar as soluções ideais para toda a indústria, incluindo imersão, placas frias, materiais de interface térmica e muitas outras. Também haverá demanda por soluções de chips com uma variedade de temperaturas de refrigerante, incluindo algumas oportunidades abaixo da meta de 30 °C. No entanto, o objetivo dessa iniciativa é visar o chip com a melhor relação preço/performance acima do limite de 30 °C do refrigerante.

Como uma indústria, pesquisadores continuam a encontrar soluções e melhorias para a infraestrutura digital crítica, incluindo tecnologias que possam estimular iniciativas empresariais e de negócios responsáveis no futuro. Por exemplo, o OCP (Open Compute Project) tem sido fundamental e continuará promovendo soluções de resfriamento que melhorem a eficiência e a confiabilidade do data center. Para encontrar as informações técnicas e os detalhes comerciais para manter temperaturas ótimas nos modernos data centers, e identificar caminhos para novos investimentos em tecnologia visando uma melhor performance no futuro, baixe o mais novo white paper do OCP "Refrigerante a 30 °C - Um Roadmap Duradouro para o Futuro". Para conhecer as implantações e implementações que facilitam essa jornada, visite Vertiv.com.