Gli operatori e i professionisti dei data center devono adattare i propri sistemi per rimanere al passo con i rapidi progressi dell'architettura basata sull'AI. I carichi di lavoro IA stanno plasmando il dibattito e i cambiamenti, diventando il principale motore per l'espansione della capacità IT, il consumo energetico e la generazione di calore. La spinta verso l'espansione delle infrastrutture e la necessità di comprendere richieste sempre più esigenti sono fondamentali per rimanere competitivi.

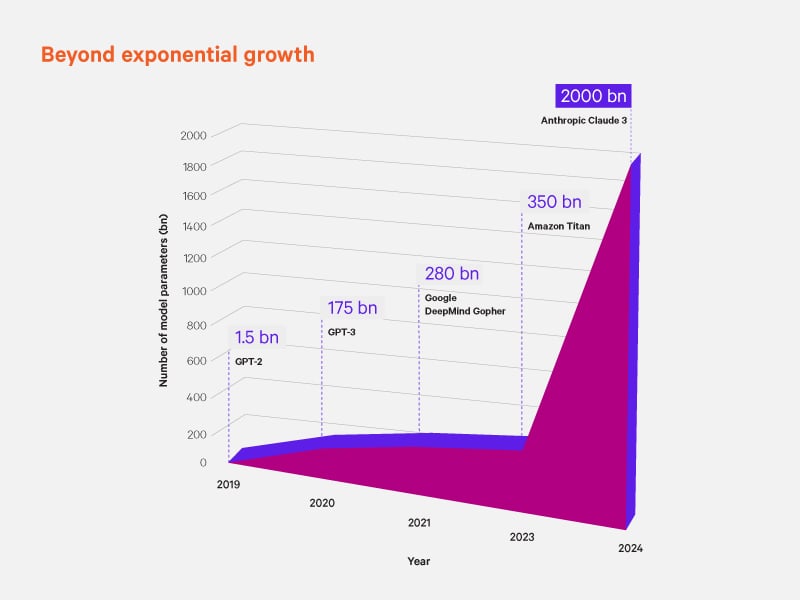

Il potenziale dell'AI di estrarre dati e ricavare informazioni preziose è simile a quello delle attività di raffinazione delle preziose risorse naturali. Gli strumenti e le infrastrutture che supportano il processo devono evolversi per gestire l'aumento del carico in modo efficiente e responsabile. Una delle tendenze più rilevanti è rappresentata dal drastico aumento della densità dei rack: si prevede che entro il 2029 le già alte densità attuali dei rack, 50 kW per rack, raggiungeranno 1 MW. Questo non è un dato casuale, ma un’anticipazione dei rapidi cambiamenti già in arrivo per aziende e data center.

La sfida legata alla domanda di energia

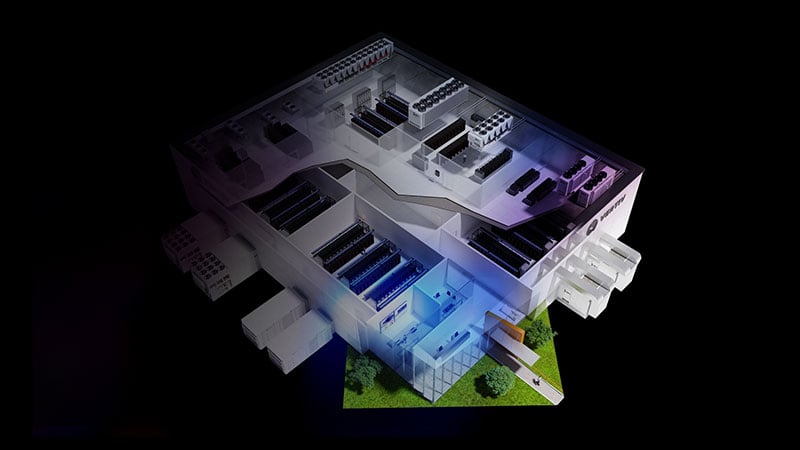

La maggiore densità dei rack comporta una potenza di calcolo superiore ma anche sfide più impegnative nella gestione del calore e del consumo energetico. Sul piano fisico e in relazione ai sistemi, una delle sfide principali è l'integrazione dei metodi di raffreddamento ad aria tradizionali con le emergenti tecniche di raffreddamento a liquido. Questi evoluti metodi di raffreddamento sono fondamentali per garantire le prestazioni e l'affidabilità del sistema all'aumentare della densità dei rack e possono migliorare l'efficienza energetica aiutando a far funzionare i data center in condizioni ottimali, evitando il provisioning eccessivo.

Inoltre, i sistemi di raffreddamento dovranno essere costantemente alimentati. La crescente domanda di energia correlata ai carichi di lavoro dell'AI ad alta intensità di processori richiede soluzioni di alimentazione sempre attive per gestire con efficacia i carichi a impulsi. In sintesi, le soluzioni di alimentazione scalabili sono tra le poche misure proattive che consentono ai data center di gestire questi picchi senza compromettere le prestazioni e l'affidabilità. Via via che il settore prende atto dei cambiamenti e degli adeguamenti in corso, la progettazione di sistemi scalabili comporta una crescente collaborazione tra i produttori di chip, i fornitori di sistemi di alimentazione e di raffreddamento e gli operatori dei data center, che cercano di difendere il proprio vantaggio sul mercato.

"Oggi uno dei nostri ruoli consiste nel rendere più disponibile l'alimentazione e garantire che venga utilizzata con più efficienza nel data center. Dobbiamo essere sicuri di utilizzare l'energia disponibile in modo efficace."

Chief Technology Officer ed Executive Vice President di Vertiv

Una gestione efficiente dell'alimentazione sarà fondamentale per sostenere la crescita dell'AI. I data center devono adottare sistemi di distribuzione dell'alimentazione più raffinati, in grado di supportare densità superiori e carichi dinamici per la gestione dei data center. Anche le innovazioni nel campo dell'energia rinnovabile e delle reti elettriche intelligenti saranno cruciali, riducendo l'impatto ambientale di queste operazioni che richiedono molta energia.

Implicazioni concrete

Gli attuali sistemi stanno avranno crescenti difficoltà nel gestire l'aumento dell'intensità dei dati e della potenza di elaborazione che i complessi modelli di AI richiedono. Con l'accelerazione nello sviluppo dell'hardware specializzato, come gli acceleratori per l'AI e le unità di elaborazione grafica (GPU) avanzate, saranno pochi i fornitori in possesso delle competenze tecniche e dell'esperienza necessarie per adeguarsi alle mutevoli esigenze delle aziende e dei data center del futuro.

Non si tratta solo dell'hardware: occorre reinventare anche l'architettura IT critica in sé. I data center tradizionali funzionano sulla base di principi che potrebbero non essere più applicabili, in un mondo incentrato sull'AI. I nuovi paradigmi architettonici, come l'edge computing e le reti distribuite, avranno un ruolo fondamentale nel garantire bassa latenza e alta produttività, che sono essenziali per le applicazioni dell’AI in tempo reale. Questa evoluzione richiederà anche nuovi progressi nei framework del software, per ottimizzare i carichi di lavoro dell'AI e gestire le complesse esigenze degli ambienti ibridi.

"I cambiamenti stanno avvenendo più velocemente che mai negli ultimi 30 anni. Per gestire questo cambiamento dobbiamo lavorare insieme, a livello di settore, per definire le best practice e i design di riferimento. L'IT è fondamentale per affrontare i cambiamenti che sono già in corso."

Vice President, Global Power, Vertiv

Ottimizzazione dell'infrastruttura IT per l'AI: Approfondimenti tratti dal nostro whitepaper

Le implicazioni del progresso dell'AI nei data center vanno oltre le sfide tecniche; offrono opportunità di crescita e innovazione senza precedenti. Agendo nel modo giusto le organizzazioni possono creare opportunità per migliorare l'efficienza e le prestazioni, ottenendo margini competitivi nei rispettivi campi.

Il nostro whitepaper "I carichi di lavoro dell'AI e il futuro dell'infrastruttura IT" contiene un'analisi delle tendenze attuali, previsioni degli esperti per quanto riguarda gli sviluppi futuri, e strategie attuabili che si possono già implementare. Questo whitepaper offre ai professionisti dei data center, ai progettisti e agli operatori una grande quantità di informazioni per preparare hyperscaler, colocation e infrastruttura IT aziendale ad affrontare il futuro.

Per crescere nella rivoluzione dell'AI non basta una semplice tecnologia all'avanguardia: sono necessarie soluzioni olistiche e partnership visionarie. Le aziende devono scegliere le proprie soluzioni con saggezza, ma la anche scelta dei partner giusti è fondamentale. Vertiv ha collaborato strettamente con i principali produttori di chip, come consulente sul panorama delle infrastrutture digitali critiche in rapida evoluzione: possiamo aiutare le aziende a preparare i loro sistemi per affrontare i progressi tecnologici futuri.

L'AI sta inevitabilmente riscrivendo il futuro dell'infrastruttura IT. Scarica il nostro whitepaper: offre le conoscenze e gli strumenti necessari per affrontare le complessità dell'AI nell'infrastruttura IT. Per ulteriori informazioni sui prossimi cambiamenti determinati dall'AI per l'infrastruttura digitale critica, esplora il Vertiv™ AI Hub.