La adopción del enfriamiento líquido ha aumentado considerablemente en años recientes debido al rápido incremento en el consumo energético de las unidades de procesamiento de gráficos/circuitos integrados de aplicación específica (GPU/ASIC) para cargas de trabajo de IA/ML. Además, los proveedores de servicios en la nube (CSP) y la adopción de OEM se incrementó a medida que el consumo energético de CPU aumentó progresivamente de un estimado de 100 W en una década, a más de 400 W en los últimos cinco años. El consumo energético de GPU/ASIC ha aumentado considerablemente en comparación con las CPU, con un crecimiento en la potencia de cientos de vatios al año. Los proveedores de silicio como NVIDIA, AMD e Intel han publicado potencias de GPU superiores a 1 kW. Además, algunos proveedores de servicios en la nube (CSP) como Microsoft, Google, Amazon y Meta están diseñando su silicio para las cargas de trabajo de IA/ML, y su silicio exigirá el enfriamiento líquido en el futuro.

En colaboración con algunos miembros del Open Compute Project (OCP), como AMD, Intel, Meta, NVIDIA, Samsung y Vertiv™, publicamos un artículo técnico titulado “El refrigerante de 30 °C: Una hoja de ruta duradera para el futuro”. La investigación ofrece información de eficiencia y planificación empresarial sobre cómo mantener las temperaturas óptimas para la longevidad del equipo, la estabilidad de la cadena de suministros y la responsabilidad ambiental.

Arquitectura de GPU: La pila térmica en el silicio moderno.

Las modernas GPU han sufrido un cambio radical en la construcción de sus paquetes de silicio, y utilizan apilamiento de múltiples conjuntos de chips de 2,5 dimensiones (2,5 D) (Chip-on-Wafer-on-Substrate o CoWoS) para mejorar el rendimiento informático. Esto implica la combinación de sistemas en chip (SoC) con memoria de alto ancho de banda (HBM), lo cual permite combinar tipos y cantidades de conjuntos de chips para paquetes de GPU de mayor rendimiento. Las mejoras en la tecnología de procesos, las técnicas de montaje de paquetes, los requisitos de rendimiento de procesamiento y la coubicación de la memoria han impulsado los grandes aumentos de potencia de procesamiento vistos en las GPU.

Al compararlas, la complejidad de la construcción de las GPU es mucho mayor que la de las CPU e igualmente presenta desafíos térmicos únicos en el paquete:

- los diferentes conjuntos de chips o componentes requieren diferentes temperaturas máximas de unión.

- Los diferentes conjuntos de chips cuentan con diferentes alturas de apilamiento.

Por ejemplo, el conjunto de chips SoC suele operar con una temperatura de unión de 105 °C, mientras que el HBM exigirá una temperatura de unión menor de 85 °C para una sola actualización y 95 °C para una operación de doble actualización en las generaciones anteriores. Las generaciones posteriores de HBM han aumentado esto a 95 °C y 105 °C, respectivamente, para ajustarse mejor a los requisitos de temperatura de unión de los SoC. Cada fabricante de HBM intenta hacer frente a esta tendencia con base en su experiencia.

La durabilidad desde la perspectiva de un fabricante y un operador

Es beneficioso para los fabricantes de silicio contar con un centro de datos duradero para establecer que los requisitos de temperatura no cambien con cada generación. Los productos de IA de última generación cuentan con diseños térmicos que requieren temperaturas de fluido considerablemente más bajas que las planificadas actualmente por algunos diseñadores de centros de datos. Al estar de acuerdo en un refrigerante estándar, los fabricantes de silicio pueden diseñar sus productos con la seguridad de que pueden enfriarse debidamente. Además, una temperatura determinada ofrece una buena dirección del diseño para los fabricantes de silicio.

Mientras tanto, los operadores de centros de datos se benefician de ajustarse a una temperatura de refrigerante de larga duración por varias razones. Aunque se necesitan muchos años para planificar, diseñar, construir y poner en marcha un centro de datos, el silicio para la IA está evolucionando rápidamente.

La industria se beneficia de las rápidas iteraciones del silicio, pero si el límite inferior del refrigerante necesario para implementar el silicio para la IA fuese a cambiar rápidamente, los nuevos centros de datos quedarían obsoletos antes de construirse. Además, es relativamente sencillo y eficiente operar un circuito de sistema de enfriamiento de tecnología (TCS) en la base de su rango de temperatura más elevada. Sin embargo, modificar un circuito TCS para operar por debajo de su rango de diseño existente después de construido resulta costoso y consume mucho tiempo. Por lo tanto, es muy importante definir el límite inferior de temperatura de un circuito TCS en un centro de datos para la viabilidad a largo plazo y la inversión en la infraestructura del centro de datos.

Determinar la temperatura adecuada para el centro de datos moderno

Los centros de datos deben diseñarse para una temperatura operativa y un caudal de refrigerante específicos. Si el requisito de temperatura para una generación particular de hardware de TI es mayor, los puntos de ajuste operativos del centro de datos pueden ajustarse para aumentar la temperatura del refrigerante. Esto ofrece la oportunidad de mejorar la eficiencia. Si el requisito de temperatura es menor a la temperatura de diseño del centro de datos, se necesitarán costosas modificaciones del diseño físico y mucho tiempo. Por ejemplo, las temperaturas más bajas pueden exigir capacidad adicional de la planta de enfriamiento o un nuevo tipo de planta de enfriamiento. Dadas las consecuencias de un cambio así, es importante establecer que el requisito de temperatura del refrigerante no cambie a lo largo de múltiples generaciones de hardware de TI.

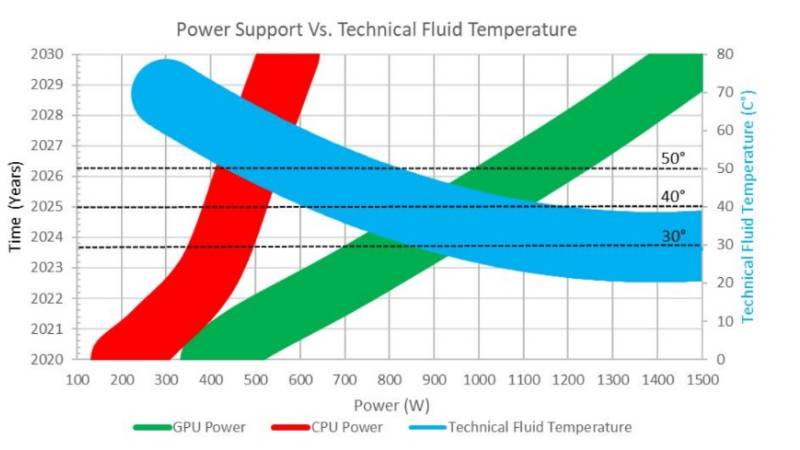

Esto supone todo un desafío para el hardware de TI, como consecuencia de los rápidos cambios en los requisitos térmicos y de alimentación del silicio. La figura 2 ilustra las tendencias de alimentación de GPU y CPU, y los requisitos técnicos de temperatura del fluido asociados (Figura 6 en el artículo técnico).

El hardware de IA impulsa la necesidad del enfriamiento líquido. La alimentación de las GPU está aumentando mucho más rápido que la alimentación de las CPU. El gráfico muestra los requisitos de temperatura de fluido asociados para las GPU a lo largo del tiempo: el requisito de temperatura asintótica es 30 °C.

Figura 2. Las tendencias de alimentación de las GPU y las CPU y los requisitos de temperatura de fluido asociados a 1,5 lpm por 1 KW. Fuente: Open Compute Project®, “Coolant Temperatures for Next Generation IT and Durable Data Center Designs”, presentación, OCP Regional Summit, abril de 2023

Acordamos los 30 °C como la temperatura de fluido mínima para el hardware y el diseño del centro de datos. El grosor de la línea representa la incertidumbre de la estimación. Se necesitan inversiones en el empaquetado avanzado del silicio y el rendimiento del enfriamiento líquido para mantener los 30 °C como especificación de interfaz a largo plazo. La elección de 30 °C coincide con una especificación de temperatura del aire mínima común para el diseño de centros de datos a gran escala. Elegir el mismo valor para el hardware de TI enfriado por líquido y por aire hace posible las notables mejoras en la efectividad del uso de la energía (PUE) alcanzadas por la industria durante los últimos 15 años. En el artículo técnico, encontrará las consecuencias de disminuir la temperatura del fluido de 30 °C a 20 °C y la reducción de las horas de free-cooling al año en zonas clasificadas con climas más cálidos.

Aunque el enfriamiento líquido en los sistemas informáticos ha existido desde hace muchas décadas, la demanda del enfriamiento de las cargas de trabajo de mayor densidad está impulsando el enfriamiento líquido desde la boutique hasta la hiperescala. Debido a la brecha de desarrollo y evolución entre las soluciones de IA y los plazos de construcción de los centros de datos, los operadores de centros de datos y los proveedores de silicio deben llegar a un acuerdo sobre la temperatura del refrigerante que permita que el silicio sea duradero.

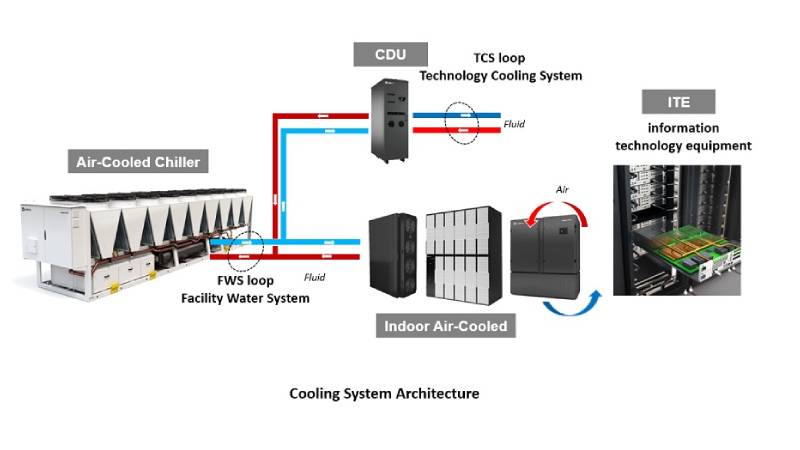

Una temperatura mínima del refrigerante de 30 °C para el circuito TCS ofrece un punto de ajuste que proporciona a ambas partes un punto de operación. A la hora de considerar una vista simplificada de la arquitectura de enfriamiento en un centro de datos, existen al menos dos circuitos de enfriamiento en un sistema de enfriamiento líquido desde el TCS hasta el sistema de agua de la instalación (FWS), como se muestra en la Figura 3 (Figura 8 en el artículo técnico).

Figura 3. Arquitectura y componentes del sistema de enfriamiento

El enfriamiento de la IA con confianza

El límite de temperatura de 30 °C del TCS no busca desalentar el desarrollo de una amplia gama de soluciones en el futuro. Si bien ajustarse a una temperatura de refrigerante de 30 °C o mayor tiene un valor significativo, no existe ningún deseo de limitar los tipos de tecnología utilizados para ofrecer la capacidad de enfriamiento al silicio. Se necesitará libertad de innovación en muchas tecnologías de enfriamiento diferentes para ofrecer soluciones ideales en toda la industria, incluida la inmersión, la placa fría, los materiales de interfaz térmica y muchos otros. También habrá demanda de soluciones de silicio en varias temperaturas de refrigerante, incluidas algunas oportunidades por debajo de la meta de 30 °C. Sin embargo, el objetivo de esta iniciativa es apuntar al silicio con la mejor relación de precio y rendimiento por encima del límite de 30 °C del refrigerante.

Como industria, los investigadores siguen encontrando soluciones y mejoras para la infraestructura digital crítica, incluidas las tecnologías que pueden impulsar los esfuerzos empresariales y de negocios responsables en el futuro. Por ejemplo, el OCP (Open Compute Project) ha sido fundamental y seguirá promoviendo soluciones de enfriamiento que mejoren y faciliten la eficiencia y la confiabilidad del centro de datos. Descargue el informe técnico más reciente de OCP “El refrigerante de 30 °C: Una hoja de ruta duradera para el futuro”, donde encontrará información técnica y detalles empresariales para mantener las temperaturas óptimas en el centro de datos moderno e identificar caminos hacia nuevas inversiones tecnológicas para un mayor rendimiento en el futuro. Para conocer las implementaciones que allanarán este camino, visite Vertiv.com.