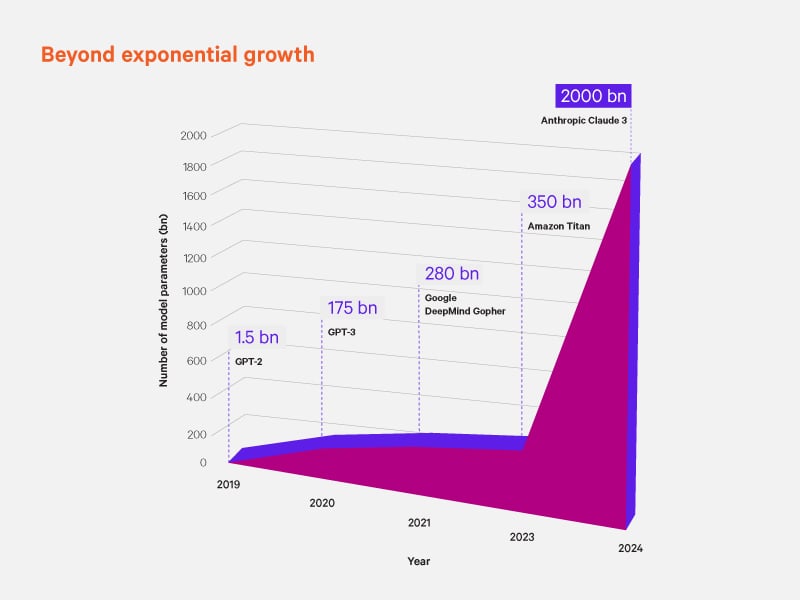

Die Betreiber von Rechenzentren und die dort tätigen Fachleute stehen vor der monumentalen Aufgabe, ihre Systeme anzupassen, damit sie mit den raschen Fortschritten in der Architektur aufgrund der KI Schritt halten können. Bei Diskussionen und Veränderungen dreht es sich um KI-Workloads. Diese werden zum primären Katalysator für die Erweiterung der Kapazitäten für IT-Verbraucher, den Energieverbrauch und die Wärmeerzeugung. Das Wachstum der Infrastruktur und die Notwendigkeit, die zunehmenden Anforderungen zu kennen, sind entscheidend für die Wettbewerbsfähigkeit.

Das Potenzial der KI für Data Mining und für die Gewinnung wertvoller Erkenntnisse ähnelt sehr der Veredelung wertvoller natürlicher Ressourcen. Die Tools und die Infrastruktur, die diesen Prozess unterstützen, müssen weiter entwickelt werden, damit sie die erhöhte Last effizient und zuverlässig bewältigen können. Einer der bemerkenswertesten Trends ist der dramatische Anstieg der Rack-Dichte: Die aktuell hohen Rack-Dichten von 50 kW je Rack werden bis 2029 voraussichtlich auf 1 MW steigen. Dieses Wachstum ist nicht bloß eine beliebige Zahl. Sie kündigt rasche Veränderungen an, die sich bei Unternehmen und Rechenzentren bereits ankündigen.

Die Herausforderung durch den Energiebedarf

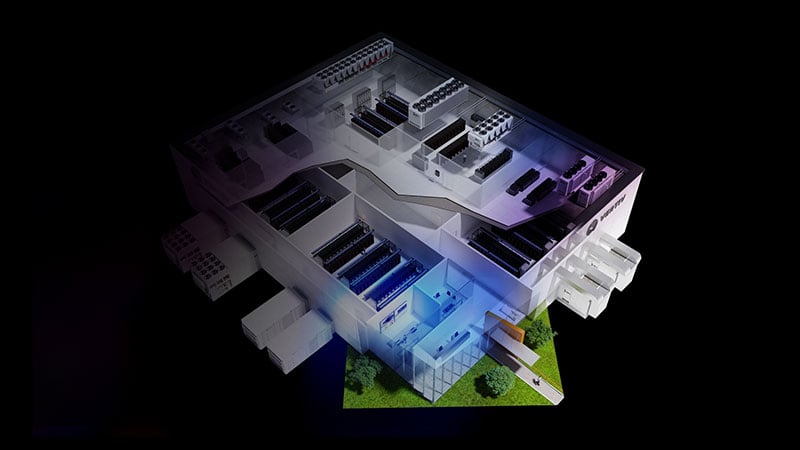

Erhöhte Rack-Dichte bedeutet höhere Rechenleistung, aber auch größere Herausforderungen bei der Wärmeabfuhr und beim Energieverbrauch. Eine der größten physikalischen und systemtechnischen Herausforderungen ist die Integration herkömmlicher Methoden der Luftkühlung und neuer Techniken der Flüssigkühlung. Diese fortschrittlichen Kühlmethoden sind entscheidend, um die Systemleistung und Zuverlässigkeit bei steigender Rack-Dichte aufrechtzuerhalten. Sie ermöglichen es Rechenzentren, unter optimalen Bedingungen zu arbeiten, ohne Überkapazitäten einzuplanen, was gleichzeitig die Energieeffizienz verbessert.

Darüber hinaus muss die Kühlung ständig mit Strom versorgt werden. Der steigende Strombedarf durch prozessorintensive KI-Workloads erfordert Lösungen für die Stromversorgung, die stets laufen, damit Impulslasten bewältigt werden können. Skalierbare Lösungen für die Stromversorgung sind im Grunde eine der wenigen proaktiven Maßnahmen, mit denen die Rechenzentren diese Stromspitzen bewältigen können, ohne an Leistung oder Zuverlässigkeit einzubüßen. Während die Branche lernt, welche Veränderungen und Anpassungen damit verbunden sind, wird die Entwicklung skalierbarer Systeme jetzt eine stärkere Zusammenarbeit zwischen Chipherstellern, Stromversorgern und den Herstellern und Anbietern für Kühlungslösungen sowie Rechenzentren mit sich bringen, wenn sie Marktführer bleiben wollen.

„Eine unserer heutigen Aufgaben besteht darin, die vorhandene Energie besser verfügbar zu machen und sicherzustellen, dass sie im Rechenzentrum effizienter genutzt wird. Wir müssen dafür sorgen, dass der verfügbare Strom effektiv genutzt wird.“

Chief Technology Officer und Executive Vice President, Vertiv

Eine effiziente Energieverwaltung wird eine zentrale Rolle dabei spielen, das Wachstum im Bereich der KI aufrecht zu erhalten. Rechenzentren müssen komplexere Stromverteilungssysteme einführen, die höhere Dichten und dynamische Lasten für den Betrieb von Rechenzentren bewältigen können. Auch Innovationen bei den erneuerbaren Energien und Smart Grids werden entscheidend dabei sein, den ökologischen Fußabdruck solcher stromhungrigen Betriebsabläufe zu reduzieren.

Reale Auswirkungen

Die derzeit verwendeten Systeme sind immer schlechter dafür gerüstet, die zunehmende Datenintensität oder Rechenleistung zu bewältigen, die von komplexen KI-Modellen benötigt wird. Der Anstieg des Tempos bei der Entwicklung spezieller Hardware, wie z.B. KI-Beschleuniger und modernste Grafikprozessoren (GPUs), setzt voraus, dass nur wenige Anbieter über das technische Know-how und die nötige Erfahrung verfügen, um mit den fortschreitenden Anforderungen an Unternehmen und Rechenzentren schrittzuhalten, die in der Zukunft betrieben werden.

Neben der Hardware muss auch die kritische IT-Architektur selbst neu konzipiert werden. Herkömmliche Rechenzentren arbeiten nach Prinzipien, die in einer KI-zentrierten Welt möglicherweise nicht mehr praktikabel sind. Neue architektonische Paradigmen wie Edge Computing und verteilte Netzwerke werden eine entscheidende Rolle dabei spielen, eine niedrige Latenz und einen hohen Durchsatz zu gewährleisten, wie sie für KI-Anwendungen in Echtzeit unverzichtbar sind. Diese Entwicklung wird auch Fortschritte bei Software-Frameworks erforderlich machen, die in der Lage sind, KI-Workloads zu optimieren und die komplexen Anforderungen hybrider Umgebungen zu bewältigen.

„Die Dinge verändern sich derzeit schneller als in den letzten 30 Jahren Um diese Veränderungen zu bewältigen, müssen wir als Branche zusammenarbeiten und Best Practices und Referenzkonzepte festlegen. Die IT ist der Schlüssel, damit wir auf die Veränderungen vorbereitet sind, die bereits stattfinden.“

Vice President, Global Power, Vertiv

Optimierung der IT-Infrastruktur für die KI: Erkenntnisse aus unserem Whitepaper

Die Auswirkungen des Fortschritts im Bereich der KI in Rechenzentren gehen über technische Herausforderungen hinaus und bieten beispiellose Chancen für Wachstum und Innovation. Wenn die Unternehmen richtig handeln, können sie die Chancen für mehr Effizienz und bessere Leistung nutzen und in ihren jeweiligen Bereichen Wettbewerbsvorteile erlangen.

Unser Whitepaper „KI-Workloads und die Zukunft der IT-Infrastruktur“ enthält eine Analyse der aktuellen Trends, Prognosen von Fachleuten zu zukünftigen Entwicklungen und nützliche Strategien, die schon heute umgesetzt werden können. Mit dem Herunterladen dieses Whitepapers erhalten Rechenzentrumsprofis, Designer und Betreiber wertvolle Informationen, um die IT-Infrastruktur von Hyperscalern, Colocation-Anbietern und Unternehmen zukunftssicher zu gestalten.

Um in der KI-Revolution erfolgreich zu sein, bedarf es mehr als nur modernster Technologie. Dafür braucht es ganzheitliche Lösungen und Partnerschaften mit einer Vision. Die Unternehmen müssen ihre Lösungen klug auswählen. Ebenso wichtig ist es aber, die richtigen Partner auszuwählen. Vertiv arbeitet eng mit den führenden Chip-Herstellern zusammen und berät sie bei der digitalen Infrastruktur, die sich rasch verändert. Daher können wir Unternehmen dabei unterstützen, ihre Systeme auf die bevorstehenden technologischen Entwicklungen vorzubereiten.

Die KI schreibt unweigerlich die Zukunft der IT-Infrastruktur neu. Laden Sie noch heute unser Whitepaper herunter und informieren Sie sich über das Know-how und die Tools, die Sie brauchen werden, um die Komplexität der KI in der IT-Infrastruktur zu bewältigen. Weitere Informationen zu den kommenden Veränderungen für die kritische digitale Infrastruktur, die die KI mit sich bringen wird, finden Sie im Vertiv™ AI Hub.